标签:10 thinking Self Attention 信息 its 机制 注意力 向量

博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看 配套 github 链接:https://github.com/nickchen121/Pre-training-language-model 配套博客链接:https://www.cnblogs.com/nickchen121/p/15105048.html注意力机制

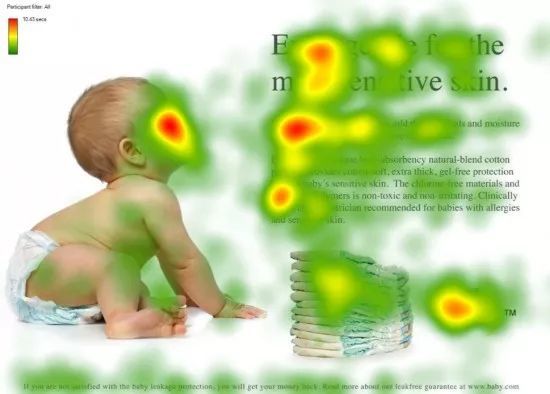

看一个物体的时候,我们倾向于一些重点,把我们的焦点放到更重要的信息上

第一眼看到这个图,不会说把所有的信息全部看完

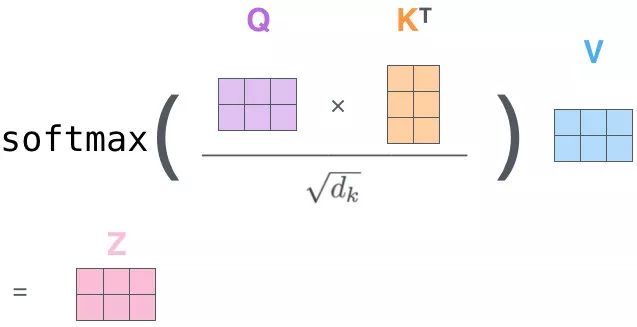

QK 相乘求相似度,做一个 scale(未来做 softmax 的时候避免出现极端情况)

然后做 Softmax 得到概率

新的向量表示了K 和 V(K==V),然后这种表示还暗含了 Q 的信息(于 Q 而言,K 里面重要的信息),也就是说,挑出了 K 里面的关键点

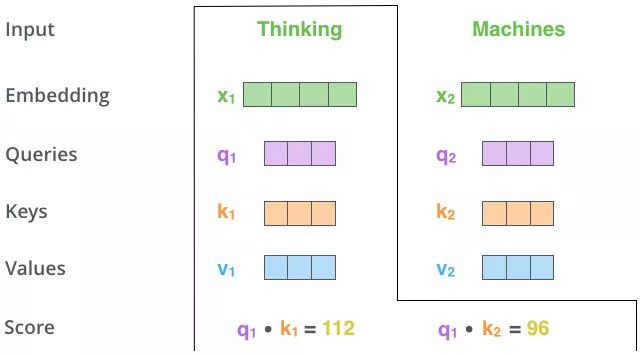

自-注意力机制(Self-Attention)(向量)

Self-Attention 的关键点再于,不仅仅是 K\(\approx\)V\(\approx\)Q 来源于同一个 X,这三者是同源的

通过 X 找到 X 里面的关键点

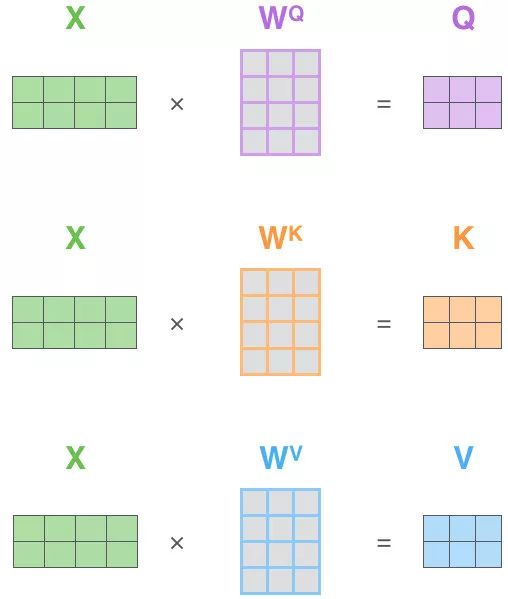

并不是 K=V=Q=X,而是通过三个参数 \(W_Q,W_K,W_V\)

接下来的步骤和注意力机制一模一样

-

Q、K、V的获取

-

-

Matmul:

-

-

Scale+Softmax:

-

-

Matmul:

-

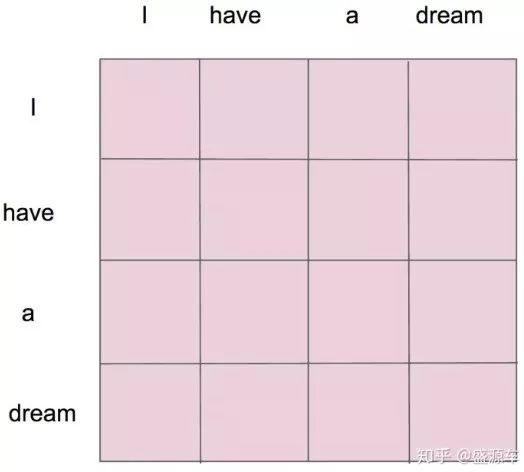

\(z_1\)表示的就是 thinking 的新的向量表示

对于 thinking,初始词向量为\(x_1\)

现在我通过 thinking machines 这句话去查询这句话里的每一个单词和 thinking 之间的相似度

新的\(z_1\)依然是 thinking 的词向量表示,只不过这个词向量的表示蕴含了 thinking machines 这句话对于 thinking 而言哪个更重要的信息

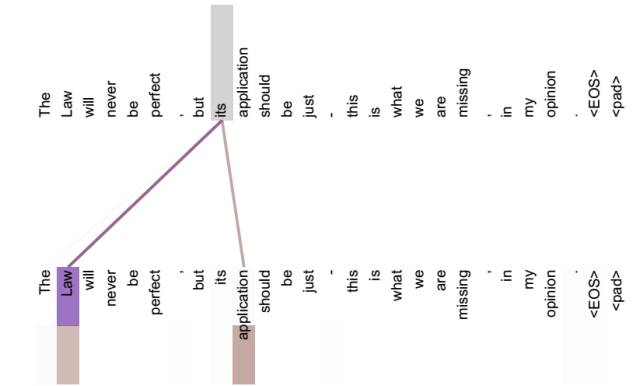

不做注意力,its 的词向量就是单纯的 its,没有任何附加信息

也就是说 its 有 law 这层意思,而通过自注意力机制得到新的 its 的词向量,则会包含一定的 laws 和 application 的信息

自注意力机制(矩阵)

标签:10,thinking,Self,Attention,信息,its,机制,注意力,向量 来源: https://www.cnblogs.com/nickchen121/p/16470711.html

本站声明: 1. iCode9 技术分享网(下文简称本站)提供的所有内容,仅供技术学习、探讨和分享; 2. 关于本站的所有留言、评论、转载及引用,纯属内容发起人的个人观点,与本站观点和立场无关; 3. 关于本站的所有言论和文字,纯属内容发起人的个人观点,与本站观点和立场无关; 4. 本站文章均是网友提供,不完全保证技术分享内容的完整性、准确性、时效性、风险性和版权归属;如您发现该文章侵犯了您的权益,可联系我们第一时间进行删除; 5. 本站为非盈利性的个人网站,所有内容不会用来进行牟利,也不会利用任何形式的广告来间接获益,纯粹是为了广大技术爱好者提供技术内容和技术思想的分享性交流网站。