标签:Producer import kafka apache API props put org Kafka

4.1 Producer API

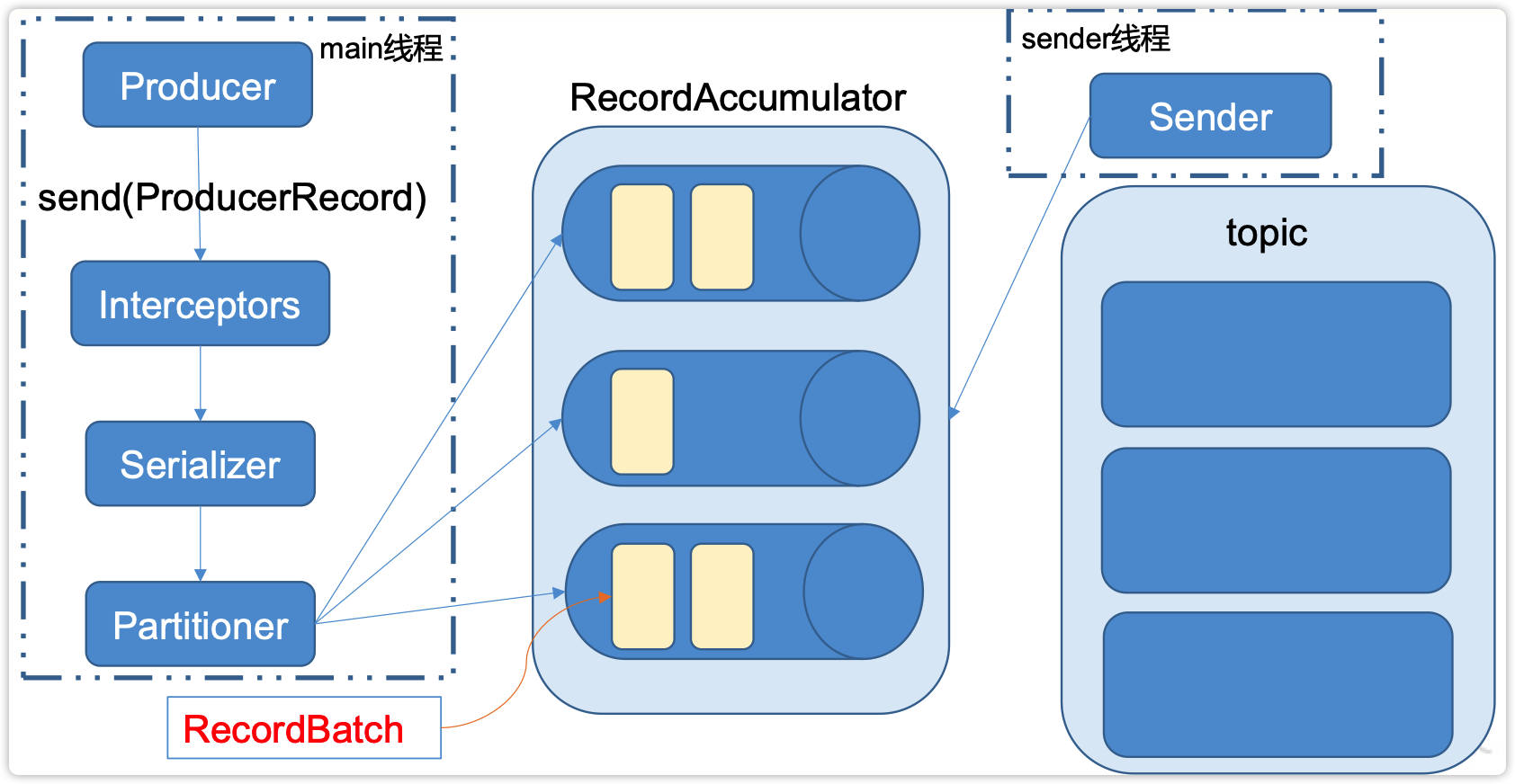

4.1.1 消息发送流程

Kafka的Producer发送消息采用的是异步发送的方式。

在消息发送的过程中,涉及到了两个线程——main线程和Sender线程,以及一个线程共享变量——RecordAccumulator。main线程将消息发送给RecordAccumulator,Sender线程不断从RecordAccumulator中拉取消息发送到Kafka broker。

相关参数:

batch.size:只有数据积累到batch.size之后,sender才会发送数据。

linger.ms:如果数据迟迟未达到batch.size,sender等待linger.time之后就会发送数据。

4.1.2 异步发送API

1)导入依赖

<dependencies>

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.4.1</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-slf4j-impl</artifactId>

<version>2.12.0</version>

</dependency>

</dependencies>

2)添加log4j配置文件

<?xml version="1.0" encoding="UTF-8"?>

<Configuration status="error" strict="true" name="XMLConfig">

<Appenders>

<!-- 类型名为Console,名称为必须属性 -->

<Appender type="Console" name="STDOUT">

<!-- 布局为PatternLayout的方式,

输出样式为[INFO] [2018-01-22 17:34:01][org.test.Console]I'm here -->

<Layout type="PatternLayout"

pattern="[%p] [%d{yyyy-MM-dd HH:mm:ss}][%c{10}]%m%n" />

</Appender>

</Appenders>

<Loggers>

<!-- 可加性为false -->

<Logger name="test" level="info" additivity="false">

<AppenderRef ref="STDOUT" />

</Logger>

<!-- loggerConfig设置 -->

<wolffy level="info">

<AppenderRef ref="STDOUT" />

</wolffy>

</Loggers>

</Configuration>

3)编写代码

需要用到的类:

KafkaProducer:需要创建一个生产者对象,用来发送数据

ProducerConfig:获取所需的一系列配置参数

ProducerRecord:每条数据都要封装成一个ProducerRecord对象

(1)不带回调函数的API

package com.wolffy.kafka.producer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

import java.util.UUID;

/**

* 生产者 - 异步发送 - 不带回调

*

* 配置类

* CommonClientConfigs : 通用的配置类

* ProducerConfig : 生产者的配置类

* ConsumerConfig : 消费者的配置类

*/

public class KafkaProducerDemo {

public static void main(String[] args) {

//0. 创建配置对象

Properties props= new Properties();

//kafka集群,broker-list

props.put("bootstrap.servers", "hadoop102:9092");

// ack的级别

props.put("acks", "all");

//重试次数

props.put("retries", 3);

//批次大小

props.put("batch.size", 16384);

//等待时间

props.put("linger.ms", 1);

//RecordAccumulator缓冲区大小

props.put("buffer.memory", 33554432); //32M

// kv的序列化器

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

//1. 创建生产者对象

KafkaProducer<String, String> kafkaProducer = new KafkaProducer<String, String>(props);

//2. 生产数据

for (int i = 0; i < 20 ; i++) {

//1. 指定partition

//kafkaProducer.send(new ProducerRecord<String,String>("first",1,null,"wolffy" + i));

//2. 指定key

//kafkaProducer.send(new ProducerRecord<String,String>("first", UUID.randomUUID().toString(),"wolffy-->" + i));

//3. 黏性

kafkaProducer.send(new ProducerRecord<String,String>("first", "wolffy*****" + i));

}

//3. 关闭对象

kafkaProducer.close();

}

}

(2)带回调函数的API

回调函数会在producer收到ack时调用,为异步调用,该方法有两个参数,分别是RecordMetadata和Exception,如果Exception为null,说明消息发送成功,如果Exception不为null,说明消息发送失败。

注意:消息发送失败会自动重试,不需要我们在回调函数中手动重试。

package com.wolffy.kafka.producer;

import org.apache.kafka.clients.producer.Callback;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import java.util.Properties;

/**

* 生产者 - 异步发送 - 带回调

*

* 配置类

* CommonClientConfigs : 通用的配置类

* ProducerConfig : 生产者的配置类

* ConsumerConfig : 消费者的配置类

*

*/

public class KafkaProducerDemo1 {

public static void main(String[] args) {

//0. 创建配置对象

Properties props= new Properties();

//kafka集群,broker-list

props.put("bootstrap.servers", "hadoop102:9092");

// ack的级别

props.put("acks", "all");

//重试次数

props.put("retries", 3);

//批次大小

props.put("batch.size", 16384);

//等待时间

props.put("linger.ms", 1);

//RecordAccumulator缓冲区大小

props.put("buffer.memory", 33554432); //32M

// kv的序列化器

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

//1. 创建生产者对象

KafkaProducer<String, String> kafkaProducer = new KafkaProducer<String, String>(props);

//2. 生产数据

for (int i = 0; i < 10; i++) {

kafkaProducer.send(

new ProducerRecord<String, String>("first", "wolffy####" + i)

, new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception exception) {

if(exception != null){

System.out.println("消息发送失败: " + exception.getMessage());

}else{

System.out.println("消息发送成功: " + metadata.topic() +

" : " + metadata.partition() +

" : " + metadata.offset()

);

}

}

});

}

//3. 关闭对象

kafkaProducer.close();

}

}

package com.wolffy.kafka.producer;

import org.apache.kafka.clients.producer.Callback;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import java.util.Properties;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.Future;

/**

* 生产者 - 同步发送 - 带回调

*

*/

public class KafkaProducerDemo2 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

//0. 创建配置对象

Properties props= new Properties();

//kafka集群,broker-list

props.put("bootstrap.servers", "hadoop102:9092");

// ack的级别

props.put("acks", "all");

//重试次数

props.put("retries", 3);

//批次大小

props.put("batch.size", 16384);

//等待时间

props.put("linger.ms", 1);

//RecordAccumulator缓冲区大小

props.put("buffer.memory", 33554432); //32M

// kv的序列化器

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

//1. 创建生产者对象

KafkaProducer<String, String> kafkaProducer = new KafkaProducer<String, String>(props);

//2. 生产数据

for (int i = 0; i < 10; i++) {

Future<RecordMetadata> future = kafkaProducer.send(

new ProducerRecord<String, String>("first", "wolffy####" + i)

, new Callback() {

/**

* 当消息发送完成后, 会调用该方法

* @param metadata 消息的元数据信息.

*

* @param exception 当消息发送过程中,如果抛出异常,会传入到该方法.

*/

@Override

public void onCompletion(RecordMetadata metadata, Exception exception) {

if (exception != null) {

System.out.println("消息发送失败: " + exception.getMessage());

} else {

System.out.println("消息发送成功: " + metadata.topic() +

" : " + metadata.partition() +

" : " + metadata.offset()

);

}

}

});

System.out.println("************** 消息发送出去 **************");

//future.get(); // 阻塞当前线程。 一直等到该方法的结果返回为止.

System.out.println("************** 消息发送完成 **************");

}

//3. 关闭对象

kafkaProducer.close();

}

}

4.1.3 分区器

1) 默认的分区器 DefaultPartitioner

2) 自定义分区器

package com.wolffy.kafka.partitioner;

import org.apache.kafka.clients.producer.*;

import java.util.Properties;

import java.util.UUID;

/**

* 生产者 - 自定义分区

*/

public class KafkaProducerPartitioner {

public static void main(String[] args) {

//0. 创建配置对象

Properties props= new Properties();

//kafka集群,broker-list

props.put("bootstrap.servers", "hadoop102:9092");

// ack的级别

props.put("acks", "all");

//重试次数

props.put("retries", 3);

//批次大小

props.put("batch.size", 16384);

//等待时间

props.put("linger.ms", 1);

//RecordAccumulator缓冲区大小

props.put("buffer.memory", 33554432); //32M

// kv的序列化器

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

// 设置分区类

props.put(ProducerConfig.PARTITIONER_CLASS_CONFIG,"com.wolffy.kafka.partitioner.MyPartitioner");

//1. 创建生产者对象

KafkaProducer<String, String> kafkaProducer = new KafkaProducer<String, String>(props);

//2. 生产数据

for (int i = 0; i < 10; i++) {

String value = "" ;

if(i % 2 == 0){

value = "wolffy==>" + i ;

}else{

value = UUID.randomUUID().toString() + "==>" + i ;

}

kafkaProducer.send(

new ProducerRecord<String, String>("first", value)

, new Callback() {

/**

* 当消息发送完成后, 会调用该方法

* @param metadata 消息的元数据信息.

*

* @param exception 当消息发送过程中,如果抛出异常,会传入到该方法.

*/

@Override

public void onCompletion(RecordMetadata metadata, Exception exception) {

if(exception != null){

System.out.println("消息发送失败: " + exception.getMessage());

}else{

System.out.println("消息发送成功: " + metadata.topic() +

" : " + metadata.partition() +

" : " + metadata.offset()

);

}

}

});

}

//3. 关闭对象

kafkaProducer.close();

}

}

package com.wolffy.kafka.partitioner;

import org.apache.kafka.clients.producer.Partitioner;

import org.apache.kafka.common.Cluster;

import java.util.Map;

/**

* 自定义分区器 需要实现Kafka提供的partitioner接口

*/

public class MyPartitioner implements Partitioner {

/**

* 计算分区号

* 以first主题为例, 有两个分区.

* 包含wolffy的消息发送0号分区

* 其他消息发送1号分区

*

*

* @param topic 当前消息发往的主题

* @param key 当前消息的key

* @param keyBytes 当前消息的key序列化后字节数组

* @param value 当前消息的值

* @param valueBytes 当前消息的值序列化后的字节数组

* @param cluster

* @return

*/

@Override

public int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster) {

if(value.toString().contains("wolffy")){

return 0 ;

}else{

return 1 ;

}

}

@Override

public void close() {

}

@Override

public void configure(Map<String, ?> configs) {

}

}

4.1.4 同步发送API

同步发送的意思就是,一条消息发送之后,会阻塞当前线程,直至返回ack。

由于send方法返回的是一个Future对象,根据Futrue对象的特点,我们也可以实现同步发送的效果,只需在调用Future对象的get方发即可。

package com.wolffy.kafka;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

import java.util.concurrent.ExecutionException;

public class CustomProducer {

public static void main(String[] args) throws ExecutionException, InterruptedException {

Properties props = new Properties();

props.put("bootstrap.servers", "hadoop102:9092");//kafka集群,broker-list

props.put("acks", "all");

props.put("retries", 1);//重试次数

props.put("batch.size", 16384);//批次大小

props.put("linger.ms", 1);//等待时间

props.put("buffer.memory", 33554432);//RecordAccumulator缓冲区大小

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

for (int i = 0; i < 100; i++) {

producer.send(new ProducerRecord<String, String>("first", Integer.toString(i), Integer.toString(i))).get();

}

producer.close();

}

}

IT学习网站

牛牛IT网站:https://www.cowcowit.com/

Kafka学习资源推荐

Kafka多维度系统精讲-从入门到熟练掌握

链接: https://pan.baidu.com/s/1fvhFRu9eExVKq8tGr3mPsw 提取码: 2mdb

--来自百度网盘超级会员v4的分享

失效加V:x923713

标签:Producer,import,kafka,apache,API,props,put,org,Kafka 来源: https://www.cnblogs.com/niuniu2022/p/16345814.html

本站声明: 1. iCode9 技术分享网(下文简称本站)提供的所有内容,仅供技术学习、探讨和分享; 2. 关于本站的所有留言、评论、转载及引用,纯属内容发起人的个人观点,与本站观点和立场无关; 3. 关于本站的所有言论和文字,纯属内容发起人的个人观点,与本站观点和立场无关; 4. 本站文章均是网友提供,不完全保证技术分享内容的完整性、准确性、时效性、风险性和版权归属;如您发现该文章侵犯了您的权益,可联系我们第一时间进行删除; 5. 本站为非盈利性的个人网站,所有内容不会用来进行牟利,也不会利用任何形式的广告来间接获益,纯粹是为了广大技术爱好者提供技术内容和技术思想的分享性交流网站。