标签:bar 复习 sum 笔记 平方和 beta 计量经济学 frac hat

根据我们之前的讨论,任意给定一组\((X,Y)\)的观测值,都可以计算回归。但是否回归都是有效的?直观说来,我们会将回归方程直接绘制在图像上,看样本点围绕回归方程的偏差程度大不大。但是绘图、看图说话总要动脑,直接给一个指标告诉大家好还是不好就能省掉许多的工作,这篇文章首先来探究这样的指标,再讨论回归方程的使用。

1、拟合优度与可决系数

如果一个回归方程的效果很好,残差就应该很小,但是这个小需要一个相对的标准进行衡量。如果只是看绝对数的大小,则样本容量小的回归方程肯定有更小的残差平方和,但拟合优度却不一定好。为了找到残差的对比指标,我们引入一个重要的等式:平方和分解式。这个等式刻画了在计算出回归方程后,离差平方和的一种分解关系,其内容如下:

\[\sum_{i=1}^n(Y_i-\bar Y)^2=\sum_{i=1}^n(Y_i-\hat Y_i)^2+\sum_{i=1}^n(\hat Y_i-\bar Y)^2,\tag{3.1} \]其中\(\sum_{i=1}^n(Y_i-\bar Y)^2\)被称为离差平方和,它就是用于计算样本方差的原始部分;\(\sum_{i=1}^n(Y_i-\hat Y_i)^2\)即残差平方和,我们总希望它尽可能小,而后面的\(\sum_{i=1}^n(\hat Y_i-\bar Y)^2\)就被我们称为回归平方和。这个式子的直观意义是,总体的方差可以被分解为确定性部分(系统性部分)与非确定性部分,回归平方和就是确定性部分,如果它越大,回归方程的解释能力就越强,残差平方和就是非确定性部分。

对这个式子的证明如下:

\[\begin{aligned} \sum_{i=1}^n(Y_i-\bar Y)^2=&\sum_{i=1}^n(Y_i-\hat Y_i+\hat Y_i-\bar Y)^2\\ =&\sum_{i=1}^n(Y_i-\hat Y_i)^2+\sum_{i=1}^n(\hat Y_i-\bar Y)^2+2\sum_{i=1}^n(Y_i-\hat Y_i)(\hat Y_i-\bar Y) \end{aligned}\tag{3.2} \]只要证明交叉部分为0即可,即

\[\begin{aligned} &\sum_{i=1}^n(Y_i-\hat Y_i)(\hat Y_i-\bar Y)\\ =&\sum_{i=1}^n[Y_i-(\hat\beta_0+\hat\beta_1X_i)](\hat\beta_0+\hat\beta_1X_i-\bar Y)\\ =&(\hat\beta_0-\bar Y)\sum_{i=1}^n[Y_i-(\hat\beta_0+\hat\beta_1X_i)]+\hat\beta_1\sum_{i=1}^nX_i[Y_i-(\hat\beta_0+\beta_1X_i)]\\ =&0. \end{aligned}\tag{3.3} \]这里又一次用到了OLS估计的条件,即\(\sum e_i=\sum X_ie_i=0\),这也说明了平方和分解式仅对OLS估计得到的回归函数生效。

有了平方和分解式,我们要衡量残差平方和的大小就有了标度——可以用残差平方和在离差平方和中的占比来表示。现在我们引入一些代号来简约地表示平方和分解式:

\[{\rm TSS}={\rm RSS}+{\rm ESS},\tag{3.4} \]这里:\({\rm TSS}\)为离差平方和(Total Sum Square),\({\rm RSS}\)为残差平方和(Residual Sum Square),\({\rm ESS}\)为回归平方和(Explained Sum Square)也就是可以用回归方程所解释的平方和。如果拟合程度比较高,则\({\rm RSS}/{\rm TSS}\)就会比较小,所以定义可决系数来表示回归方程的拟合效果:

\[R^2=1-\frac{\rm RSS}{\rm TSS}\in[0,1].\tag{3.5} \]\(R^2\)越大,则回归函数的拟合程度就越高,如果\(R^2=1\),则完全不存在随机性。

事实上,平方和分解式属于数理统计里方差分析的一部分,且可以从二元拓展到多元,导出总离差阵与组内离差阵、组间离差阵之间的关系,但在这里不需要多作扩展。有关于平方和的分布问题,也在多元情况再加以讨论,这是一类比较实用的随机变量。

2、一元线性回归下可决系数的计算

对于一元线性回归问题,可决系数\(R^2\)有着更为简便的计算方式。现在由(3.5),

\[R^2=\frac{\rm ESS}{\rm TSS}=\frac{\sum(\hat Y_i-\bar Y)^2}{\sum(Y_i-\bar Y)^2},\tag{3.6} \]引入中心化数据\(x_i=X_i-\bar X\)和\(y_i=Y_i-\bar Y\),就有

\[\begin{aligned} R^2=&\frac{\sum(\hat Y_i-\bar Y)^2}{\sum (Y_i-\bar Y)^2}\\ =&\frac{\sum[\hat\beta_0+\hat\beta_1X_i-(\hat\beta_0+\hat\beta_1\bar X) ]^2}{\sum y_i^2}\\ =&\frac{\sum(\hat\beta_1x_i)^2}{\sum y_i^2}\\ =&\hat\beta_1^2\left(\frac{\sum x_i^2}{\sum y_i^2}\right). \end{aligned}\tag{3.7} \]于是我们可以只使用回归系数与这两个用于计算回归系数的数据计算可决系数\(R^2\)。

并且,在一元线性回归情形下\(R^2\)还与\(X,Y\)的相关系数\(r\)有关,我们知道

\[r=\frac{\sum x_iy_i}{\sqrt{\sum x_i^2\sum y_i^2}},\tag{3.8} \]所以

\[r^2=\frac{(\sum x_iy_i)^2}{\sum x_i^2\sum y_i^2},\tag{3.9} \]而

\[\hat\beta_1=\frac{\sum x_iy_i}{\sum x_i^2},\tag{3.10} \]所以

\[R^2=\hat\beta_1^2\left(\frac{\sum x_i^2}{\sum y_i^2}\right)=\frac{(\sum x_iy_i)^2}{\sum x_i^2\sum y_i^2}=r^2,\tag{3.11} \]这就将可决系数与相关系数之间建立了巧妙的联系。

在我们之前的案例中,还剩下一些数据没有处理,我们现在来看看这些数据。

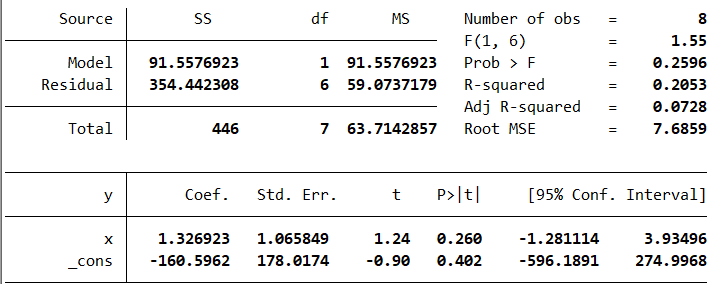

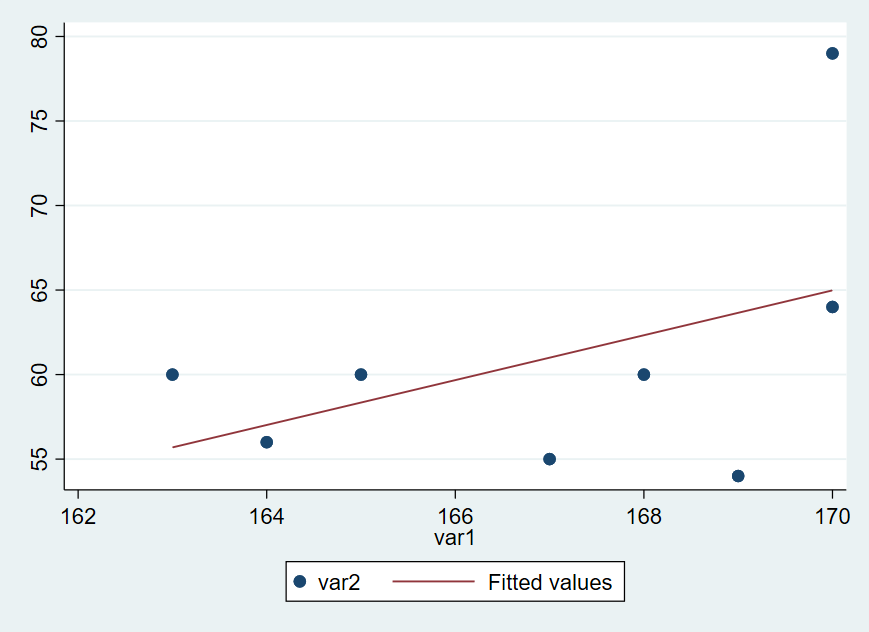

平方和分解式中的TSS、ESS、RSS分别代表图上的Total SS、Model SS、Residual SS。用Model SS除以Total SS得到可决系数,右上角的R-square就是可决系数\(R^2\),只有0.2053,属于比较低的,所以拟合效果并不是很好。图示如下:

前面得到的回归分析表中,还有一系列参数没有解释,除了Number of obs显然是观测数以外,F(1, 6)、Prob > F、Adj R-square、Root MSE都是什么意思?df、MS、Std.Err又代表什么?这些问题在我们复习到多元线性回归的时候会一起讨论。

3、用回归方程进行预测

如何使用回归方程进行预测?这看起来是一个不怎么需要思考的问题——获得解释变量\(X\)的水平,代入样本回归线直接算出预测值\(\hat Y=\hat\beta_0+\hat\beta_1X\)即可。但站在数理统计的角度来看,这样的回答是不能令人满意的,因为我们知道,点估计尽管具有一系列优良性质,但是它的预测准确率为0,反映出的信息不足。

举个例子,通过我们的预测,在\(x_0\)水平下的预测值是\(y_0\),但我们实际观测时很可能得不到\(y_0\)这个精确的值。那我们要怎么评估这个模型是异常的呢?出现\(y_0-1\)是正常情况吗?出现\(y_0-100\)呢?这些问题点估计是难以回答的,所以我们需要区间估计。

由于我们知道了\(\hat\beta_0,\hat\beta_1\)的分布,也知道了\(\hat\beta_0,\hat\beta_1\)的相关关系,现在对于给定的观测值\(X_0\),我们就可以计算与之对应的\(Y_0\)的分布。由于

\[Y_0=\beta_0+\beta_1X_0+\mu_0,\tag{3.12} \]如果用\(\hat\beta_0,\hat\beta_1\)作为\(\beta_0,\beta_1\)的估计,就有

\[\hat Y_0=\hat\beta_0+\hat\beta_1X_0,\tag{3.13} \]由于\(\hat\beta_0,\hat\beta_1\)是线性无偏的,且二者通过底层随机误差项相关联,所以线性组合仍然是正态分布,且

\[\begin{aligned} \mathbb E(\hat Y_0)=&\mathbb E(\hat\beta_0+\hat\beta_1X_0)=\beta_0+\beta_1X_0,\\ \mathbb D(\hat Y_0)=&\mathbb D(\hat\beta_0)+X_0^2\mathbb D(\hat \beta_1)+2X_0{\rm Cov}(\hat\beta_0,\hat\beta_1)\\ =&\frac{(\sum X_i^2)\sigma^2}{n\sum x_i^2}+\frac{X_0^2\sigma^2}{\sum x_i^2}-\frac{2X_0\bar X\sigma^2}{\sum x_i^2}\\ =&\frac{\frac1n\sum X_i^2+X_0^2-2X_0\bar X}{\sum x_i^2}\sigma^2\\ =&\frac{\frac1n\sum x_i^2+(\bar X-X_0)^2}{\sum x_i^2}\sigma^2 \end{aligned}\tag{3.14} \]结合其正态性,就有

\[\hat Y_0\sim N\left(\beta_0+\beta_1X_0,\left[\frac1n+\frac{(\bar X-X_0)^2}{\sum x_i^2} \right]\sigma^2 \right).\tag{3.15} \]由于\(Y_0\)的真值只依赖于\(\mu_0\),\(\hat Y_0\)的值只依赖于\(\hat\beta_1,\hat\beta_0\),也就只依赖于\(\mu_1,\cdots,\mu_n\),所以\(Y_0\)与\(\hat Y_0\)实际上是相互独立的,我们可以求预测误差的分布:

\[Y_0 - \hat Y_0\sim N\left(0, \left[1+\frac1n+\frac{(\bar X-X_0)^2}{\sum x_i^2} \right]\sigma^2 \right).\tag{3.16} \]从而在给定\(\hat Y_0\)的情况下,\(Y_0\)的条件分布就是

\[Y_0|\hat Y_0\sim N\left(\hat Y_0,\left[1+\frac1n+\frac{(\bar X-X_0)^2}{\sum x_i^2} \right]\sigma^2 \right).\tag{3.17} \]这部分的逻辑十分清晰,但如果你只是想到了直接代入求算这一步,就会觉得这样做十分繁琐。其实,研究\(Y_0\)的条件分布是十分有必要的,这样我们就能在得到\(Y_0\)的预测值的前提下,构造出\(Y_0\)的置信区间,如果\(Y_0\)的真值在置信区间以外,就要考虑是不是出现什么问题了。当然,由于\(\sigma^2\)始终是待估参数,我们总要用\(\hat\sigma^2=\sum e_i^2/(n-2)\)替代。

至此,一元线性回归部分就结束了,在这一章里,需要掌握的内容有:

- 总体/样本回归函数/模型的概念辨析,以及什么时候该用什么。

- 根据观测值求一元线性回归模型参数的点估计。(粗糙地使用假设)

- 知道一元线性回归模型是BLUE,这一点不依赖于正态性假设。

- 在正态性假设下,估计随机误差方差\(\sigma^2\),从而得到\(\hat\beta_0,\hat\beta_1\)的分布。

- 根据\(\hat\beta_0,\hat\beta_1\)的分布,解决相关区间估计、假设检验问题。

- 衡量模型的拟合优度,知道一元线性回归下可决系数的计算。

- 根据回归模型,给出预测值的区间估计。

下一章我们就将转向多元线性回归模型,在这里,矩阵计算将发挥重要的作用。

标签:bar,复习,sum,笔记,平方和,beta,计量经济学,frac,hat 来源: https://www.cnblogs.com/jy333/p/14316860.html

本站声明: 1. iCode9 技术分享网(下文简称本站)提供的所有内容,仅供技术学习、探讨和分享; 2. 关于本站的所有留言、评论、转载及引用,纯属内容发起人的个人观点,与本站观点和立场无关; 3. 关于本站的所有言论和文字,纯属内容发起人的个人观点,与本站观点和立场无关; 4. 本站文章均是网友提供,不完全保证技术分享内容的完整性、准确性、时效性、风险性和版权归属;如您发现该文章侵犯了您的权益,可联系我们第一时间进行删除; 5. 本站为非盈利性的个人网站,所有内容不会用来进行牟利,也不会利用任何形式的广告来间接获益,纯粹是为了广大技术爱好者提供技术内容和技术思想的分享性交流网站。